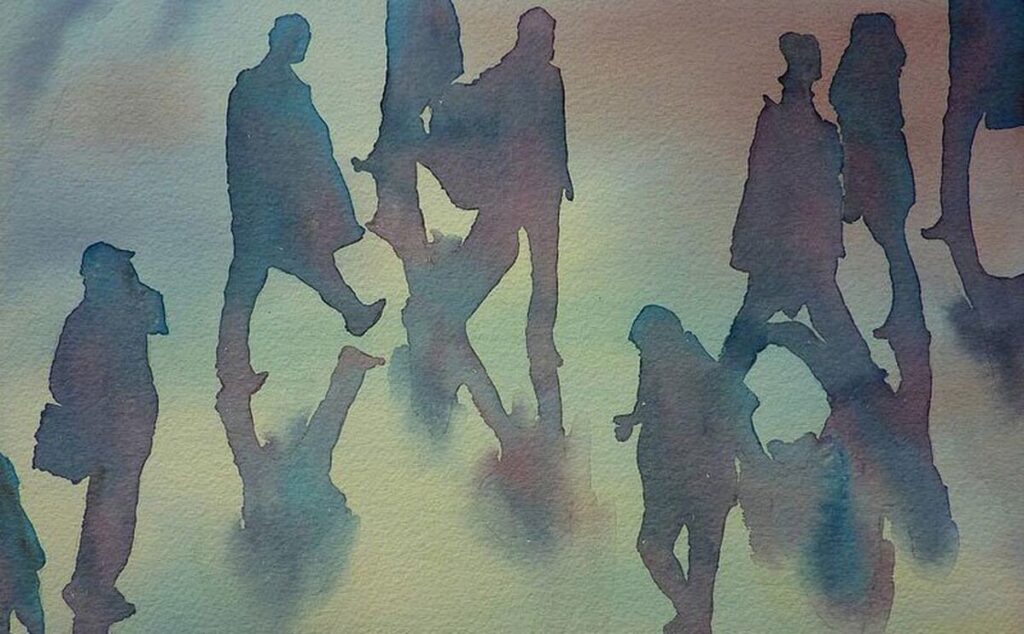

برنامهی اسکان بشر سازمان ملل متحد برای افغانستان درتازهترین مورد اعلام کرده است که هر انسان سزاوار داشتن مکانی امن است که آن را خانه بماند. این نهاد امروز (یکشنبه، ۳ حوت) با نشر پیامی در حساب کاربری ایکس خود نوشته است که خانهی مناسب از سلامت افراد محافظت کرده و مانع اخراج و بیسرپناهی آنها میشوند. سازمان ملل متحد در ادامه تاکید کرده است که داشتن خانهی مناسب یک حق بشری است، نه یک امتیاز. این در حالی است که در سراسر افغانستان میلیونها تن از نداشتن سرپناه مناسب رنج میبرند و میلیونها تن دیگر نیز در خانههای اجارهای و غیرمعیاری زندگی میکنند. نداشتن خانهای از خود برای شهروندان به ویژه در شهرهای بزرگ مانند کابل، هرات، بلخ و... سبب شده که شمار زیادی از شهروندان به اعمال فشار از سوی مالکان روبرو شوند.